Face à o1 d’OpenAI, le chinois DeepSeek dégaine le LLM R1

Avec sa licence MIT et ses coûts très bas, le dernier grand modèle de langage capable de raisonnement complexe R1 de DeepSeek est disponible en open source. Et il pourrait bien constituer une alternative attrayante et rentable pour les entreprises à o1 d’OpenAI.

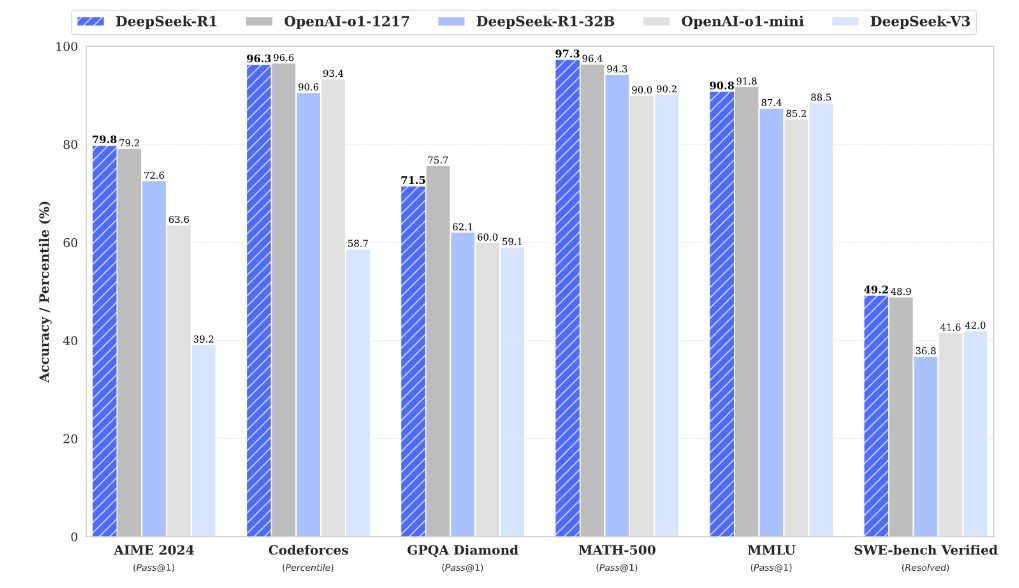

Positionné – comme bien d’autres en ce moment – sur le bouillonnant marché de la GenAI, le chinois DeepSeek va de l’avant. La start-up a donc dévoilé une version open source de son grand modèle de langage (LLM) capable de raisonnement complexe, R1, comprenant 671 milliards de paramètres et revendiquant des performances supérieures à o1 d’OpenAI sur des critères clés. « DeepSeek-R1 atteint un score de 79,8 % Pass@1 sur AIME 2024, dépassant légèrement OpenAI-o1-1217 », a déclaré l’entreprise dans un document technique. « Sur MATH-500, il atteint un score impressionnant de 97,3 %, avec des performances équivalentes à celles d’OpenAI-o1-1217 et nettement supérieures à celles des autres LLM. Pour les tâches liées au codage, DeepSeek-R1 a obtenu une note Elo de 2 029 sur Codeforces et a surpassé 96,3 % des participants humains lors d’une compétition, a ajouté l’entreprise.

« Pour les tâches liées à l’ingénierie, DeepSeek-R1 est légèrement plus performant que DeepSeek-V3 [un autre modèle de l’entreprise], ce qui pourrait aider les développeurs dans des tâches réelles », a déclaré la société chinoise. R1 est disponible sur la plateforme de développement IA Hugging Face sous licence MIT, permettant une utilisation commerciale sans restriction. L’entreprise propose également des versions de son modèle, allant de 1,5 milliard à 70 milliards de paramètres, la plus petite pouvant fonctionner sur un ordinateur portable. La version complète de R1, qui nécessite un matériel plus puissant, est disponible via une API à des coûts jusqu’à 95 % inférieurs à ceux d’o1. En tant que modèle de raisonnement, R1 vérifie lui-même ses résultats, ce qui permet de réduire les erreurs courantes dans les autres modèles. Bien que plus lents, les modèles de raisonnement offrent une fiabilité accrue dans des domaines tels que la physique, les sciences et les mathématiques.

Un retard chinois à combler face aux Etats-Unis

La course à la construction de modèles de langage s’est intensifiée, notamment en raison de l’évolution des réalités géopolitiques. « Si OpenAI et d’autres entreprises basées aux États-Unis ont incontestablement l’avantage du premier arrivé, la Chine a beaucoup investi dans l’IA pour renforcer ses capacités et devenir un bon second arrivé », a déclaré Sharath Srinivasamurthy, vice-président associé d’IDC. Dans les applications d’entreprise réelles, les performances de DeepSeek-R1 sur les mesures clés se traduisent par des capacités améliorées en matière de raisonnement mathématique, de résolution de problèmes et de tâches de codage.

Performances comparées de DeepSeek-R1 face à d’autres LLM. (crédit : DeepSeek)

« Bien que cela suggère que DeepSeek-R1 pourrait potentiellement surpasser o1 d’OpenAI dans des scénarios pratiques nécessitant ces compétences spécifiques, le résultat final dépend encore de divers facteurs au sein de l’écosystème d’IA plus large, tels que la préparation à l’IA des données, le support des RAG et des agents, les intégrations des chaînes d’outils ModelOps et DevOps, le soutien de l’infrastructure cloud et des données, et la gouvernance de l’IA », a déclaré Charlie Dai, vice-président et analyste principal chez Forrester. En outre, si les performances supérieures annoncées par R1 sont attrayantes, son efficacité réelle reste incertaine en raison d’un manque de clarté concernant les données sur lesquelles il a été formé. « Les modèles ne valent que ce que valent les données sur lesquelles ils ont été formés », a déclaré M. Srinivasamurthy. « Avec les politiques restrictives de la Chine en matière de consommation et de publication de données, il est possible que les données soient biaisées ou incomplètes. M. Srinivasamurthy a également noté que le véritable potentiel des LLM réside dans le traitement de modalités multiples telles que le texte et les images. Bien que de nombreux modèles y soient parvenus, R1 a cependant encore une marge de progression pour devenir une solution complète.

Un potentiel d’utilisation par les entreprises

La licence MIT de DeepSeek-R1, qui propose une utilisation commerciale et une personnalisation sans restriction, ainsi que ses coûts réduits, en font une option attrayante et rentable pour l’adoption par les entreprises. Cependant, elles devront peut-être prendre en compte les coûts supplémentaires associés à la licence MIT, tels que la personnalisation, le fine tuning et l’adaptation du modèle pour répondre aux besoins spécifiques de l’entreprise pour obtenir un meilleur retour sur investissement, selon Mansi Gupta, analyste principal chez Everest Group.

Les sociétés situées en dehors de la Chine peuvent également être réticentes à utiliser leurs données pour former le modèle ou l’intégrer dans leurs opérations en raison des défis réglementaires qui affectent l’adoption de l’IA. « Les entreprises doivent évaluer soigneusement les risques géopolitiques liés à l’utilisation de l’IA, en particulier pour leus opérations mondiales », a déclaré M. Gupta. « Il s’agit notamment de naviguer dans les réglementations chinoises et de mener des évaluations de conformité et des analyses de risques approfondies. En fin de compte, l’adoption de R1 dépendra de la capacité des entreprises à optimiser le compromis entre son retour sur investissement potentiel et ces défis géopolitiques et réglementaires. »