Google lance une bibliothèque de surveillance TPU

Intégrée à LibTPU, la bibliothèque de surveillance TPU fournit des données télémétriques détaillées, des mesures de performances et des outils de débogage pour aider les entreprises à optimiser leurs charges de travail IA sur les unités de traitement Tensor Google Cloud.

Google a présenté une bibliothèque de surveillance afin d’améliorer l’efficacité des ressources de ses unités de traitement Tensor (TPU) à mesure que les entreprises augmentent leurs charges de travail IA pour répondre à la demande croissante de leurs clients et de leurs propres services, tout en gérant leurs coûts. La bibliothèque de surveillance TPU est intégrée à LibTPU, la base fondamentale qui permet aux frameworks d’apprentissage automatique tels que JAX, PyTorch et TensorFlow d’exécuter des modèles sur les TPU Google Cloud. « La bibliothèque de surveillance TPU vous fournit (aux utilisateurs professionnels) des informations détaillées sur les performances des charges de travail de machine learning sur le matériel TPU. Elle est conçue pour vous aider à comprendre l’utilisation de vos TPU, à identifier les goulots d’étranglement et à déboguer les problèmes de performances », explique Google dans sa documentation.

Si la bibliothèque utilise une API de télémétrie et une suite de métriques pour fournir des informations détaillées sur les performances opérationnelles et le comportement des TPU, elle fournit également un kit de développement logiciel (SDK) et une interface de ligne de commande (CLI) comme outils de diagnostic afin de permettre aux entreprises d’effectuer une analyse approfondie des performances des ressources TPU et de procéder au débogage. L’observabilité et la connaissance des performances de l’infrastructure IA sont des domaines critiques pour les entreprises lorsqu’il s’agit de faire évoluer leurs charges de travail IA, a déclaré Charlie Dai, vice-président et analyste principal chez Forrester. « Selon l’enquête Tech Pulse de Forrester réalisée au quatrième trimestre 2024, 85 % des décideurs informatiques se concentrent sur l’observabilité et l’AIOps en général », a ajouté M. Dai.

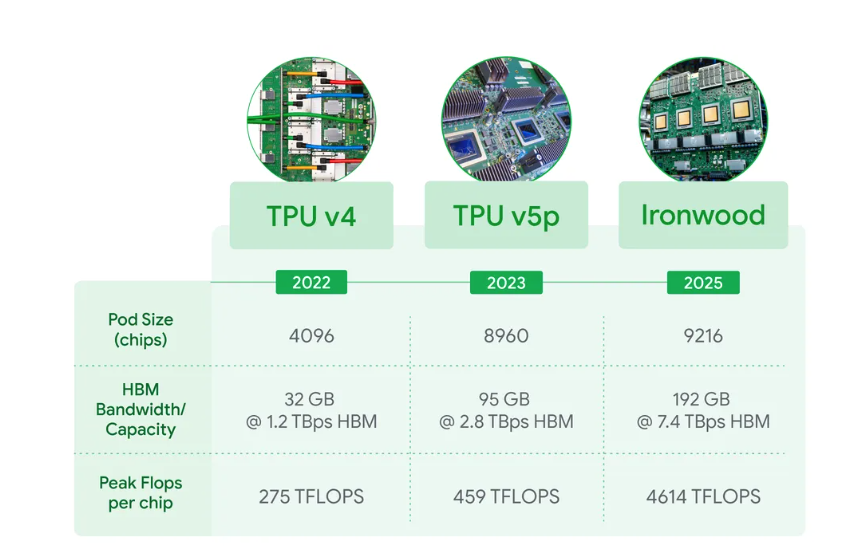

Les accélérateurs TPU (Tensor Processor Unit) de Google avec la dernière génération baptisée Ironwood. (Crédit Google)

La bibliothèque de surveillance TPU de Google propose au moins sept indicateurs que les entreprises peuvent utiliser pour déterminer l’utilisation et l’efficacité des TPU. Ces indicateurs comprennent l’utilisation du Tensor Core, qui mesure l’efficacité avec laquelle les cœurs spécialisés du TPU sont utilisés pendant les opérations, et l’indicateur de pourcentage de cycle de service, qui révèle le niveau d’activité de chaque processeur TPU au fil du temps. Elle propose également les indicateurs « HBM Capacity Total » et « HBM Capacity Usage », qui suivent respectivement l’utilisation totale et active de la mémoire à bande passante élevée. Pour les performances réseau, la métrique « Buffer Transfer Latency » est utilisée pour capturer les distributions de latence pour les transferts de données à grande échelle, ce qui permet d’identifier les goulots d’étranglement dans la communication, explique Google dans sa documentation. En outre, la bibliothèque comprend des mesures de distribution du temps d’exécution des opérations de haut niveau (HLO), qui fournissent des détails sur le timing des opérations compilées, et la taille de la file d’attente HLO, qui surveille la congestion du pipeline d’exécution.

AWS et Microsoft disposent également d’outils similaires

Cependant, Google n’est pas le seul fournisseur d’infrastructure IA à proposer des outils permettant d’optimiser les performances et l’utilisation des ressources (accélérateurs CPU, GPU). Son rival AWS propose aux entreprises de nombreuses façons d’optimiser le coût d’exécution de leurs charges de travail d’IA tout en garantissant une utilisation maximale de leurs ressources. Pour commencer, il fournit CloudWatch, un service capable d’offrir une observabilité de bout en bout des charges de travail de formation exécutées sur ses puces Trainium et Inferentia, y compris des mesures telles que l’utilisation des GPU/accélérateurs, la latence, le débit et la disponibilité des ressources. Les services AWS tels que SageMaker, via des offres comme SageMaker HyperPod, permettent également une utilisation plus efficace des ressources tout en réduisant le temps de formation. Contrairement au processus manuel de formation des modèles, qui est sujet à des retards, des dépenses inutiles et d’autres complications, HyperPod élimine les tâches fastidieuses liées à la création et à l’optimisation de l’infrastructure d’apprentissage automatique pour les modèles de formation, réduisant ainsi le temps de formation jusqu’à 40 %, selon AWS.

À l’instar de la bibliothèque de surveillance TPU, Microsoft propose Maia SDK comme boîte à outils principale pour optimiser l’exécution des modèles pour ses puces Azure Maia, ainsi que des outils de développement tels que Maia Debugger et Profiler pour le débogage et le suivi, a déclaré M. Dai. Bien que ses concurrents proposent des outils similaires, ce dernier a souligné que la bibliothèque de surveillance devrait aider efficacement Google Cloud à étendre davantage sa présence sur le marché du cloud d’infrastructure native pour l’IA.