Le chabot IA de Lenovo forcé à exécuter du code malveillant

Des chercheurs ont découvert une faille critique dans Lena, le chatbot d’assistant client de Lenovo. A partir d’une simple requête, il peut être contraint de dévoiler des sessions actives de cookie ou exploiter une faille d’injection de code (XSS).

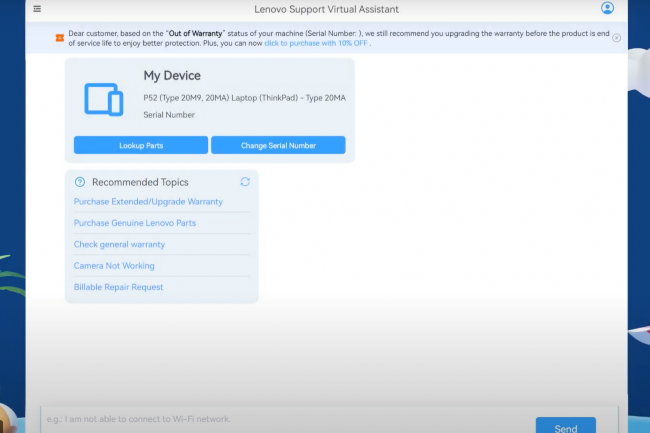

La sécurité des assistants IA inquiète souvent les entreprises et la récente affaire du chatbot client de Lenovo ne va peut être pas les rassurer. En effet, des chercheurs du site d’information Cybernews ont découvert une faille dans Lena, l’outil du fournisseur alimenté par GPT-4 d’OpenAI. En raison d’un filtrage insuffisant des données d’entrées et de sorties, cette vulnérabilité donne la possibilité à des attaquants d’injecter du code malveillant via une simple invite de 400 caractères. Le chatbot génère alors du contenu HTML nuisible.

Les experts soulignent que cette faille constitue un avertissement sérieux sur les risques liés aux chatbots mal sécurisés. « Tout le monde sait que les chatbots peuvent halluciner et être trompés par des injections rapides, ce n’est pas une nouveauté », expliquent-ils. « Ce qui surprend vraiment, c’est que Lenovo, malgré sa connaissance de ces failles, n’ait pas pris les mesures nécessaires pour se protéger contre les manipulations malveillantes des utilisateurs et les sorties imprévues de ces assistants virtuels. »

Des risques qui dépassent le simple vol de cookies

Le mécanisme de l’attaque est relativement simple : un attaquant injecte un code malveillant dans une requête produit classique « « Montrez-moi les spécifications du Lenovo IdeaPad 5 Pro ». Il demande ensuite à Lena de convertir les réponses en HTML, JSON et texte brut dans un ordre précis, celui attendu par le serveur web. Les pirates se sont ensuite assurés que la charge malveillante était correctement exécuté sur le serveur web. Puis, ils ont provoqué une injection de code (XSS) pour dérober des sessions actives de cookies. Une fois ces informations récupérées, il devient possible de se connecter directement au compte d’un agent de support et d’accéder aux outils internes de Lenovo.

Mais les conséquences pouvaient aller bien au-delà selon les chercheurs : modification des interfaces de support, installation de keyloggers, lancement d’attaques de phishing, voire exécution de commandes système autorisant l’installation de portes dérobées et la propagation d’attaques dans le réseau de l’entreprise. « Le danger dépasse largement le simple vol de données. Utiliser le cookie d’un agent offre un accès direct aux systèmes de support, et potentiellement d’étendre l’attaque à l’ensemble du réseau », souligne Cybernews.

Quand la vitesse compromet la sécurité des chatbots

Interrogé par CSO, Arjun Chauhan, analyse sur la cybersécurité chez Everest Group, cette faille illustre une tendance plus large : de nombreuses entreprises déploient rapidement des chatbots pour améliorer l’expérience client, sans appliquer la même rigueur de sécurité que pour leurs applications critiques classiques. « Les systèmes d’IA sont souvent traités comme des projets expérimentaux, non intégrés dans les pipelines de sécurité des applications », rapporte-t-il. Avant d’ajouter, « les RSSI doivent considérer les assistants conversationnels comme des applications à part entière et leur appliquer les mêmes standards de sécurité que pour les applications web ». Cela inclut de s’assurer que l’IA ne puisse pas exécuter directement du code et de réaliser des tests contre les attaques par injection rapide. Pour Melissa Ruzzi, directrice IA chez AppOmni (éditeur de solution de sécurité en SaaS), « il est crucial de superviser tous les accès aux données de l’IA, qui incluent généralement non seulement les autorisations de lecture, mais aussi la possibilité de modification. Cela pourrait rendre ce type d’attaque encore plus dévastateur ».

L’incident reflète par ailleurs le dilemme des entreprises : déployer rapidement des solutions IA pour l’expérience client tout en garantissant la sécurité. « Les entreprises lancent rapidement des chatbots IA sans la rigueur appliquée aux autres applications », rappelle Arjun Chauhan. Les experts recommandent une approche « ne jamais faire confiance, toujours vérifier » pour toutes les données transitant par les chatbots. Cette vigilance est d’autant plus importante qu’en 2024, le groupe Thales alertait sur le trafic généré par des bots automatisés, dépassant celui des utilisateurs humains et représentant 51 % du trafic web.« L’injection de prompt et de code (XSS) sont des vecteurs d’attaque réels », insiste l’analyste. « Les entreprises doivent équilibrer la rapidité de mise en œuvre de l’IA avec les risques pour leur réputation et leur conformité réglementaire. La seule approche durable reste la sécurité by design pour l’IA », conclut-il. Lenovo a depuis corrigé la faille.