Pour les agents IA, JetBrains muscle son framework Koog

La dernière mise à jour 0.4.0 du framework Koog de JetBrains basé sur son langage de programmation Kotlin prend en charge les modèles GPT-5, OpenTelemetry et ajoute également le support d’iOS d’Apple.

Annoncée le 28 août, la dernière version 0.4.0 du framework de gestion et de création d’agents IA Koog est destinée à les rendre observables, transparents, déployables dans la pile d’un utilisateur et plus prévisibles. « Elle supporte aussi d’autres plateformes et modèles », a indiqué JetBrains. Le code est accessible depuis GitHub. La sortie structurée (structured output) native répond à une situation dans laquelle un grand modèle de langage (LLM) peut fournir le format de données exact nécessaire, mais où le processus cesse ensuite de fonctionner. La sortie structurée native fournie par Koog 0.4.0 est prise en charge par certains LLM, avec des garde-fous (stratégies de ré-essai, correction…). Lorsqu’un modèle prend en charge la sortie structurée, le framework l’utilise directement. Le cas échéant, Koog se contente d’un « prompt-and-retry » personnalisé avec un analyseur syntaxique de correction alimenté par un modèle distinct, jusqu’à ce que la charge utile ressemble exactement à ce qu’elle devrait être.

Par ailleurs, Koog – qui s’appuie sur le langage de programmation Kotlin – est désormais disponible sur le système d’exploitation mobile iOS d’Apple dans le cadre d’une stratégie axée sur Kotlin Multiplatform. Les développeurs peuvent créer un agent une seule fois et le déployer sur les back-ends iOS, Android et JVM, le tout avec les mêmes graphes stratégiques, les mêmes hooks d’observabilité et les mêmes tests. A noter qu’une mise à jour corrrective (0.4.1) est requise pour créer des applications pour iOS.

W&B Weave AI et Langfuse d’OpenTelemetry de la partie

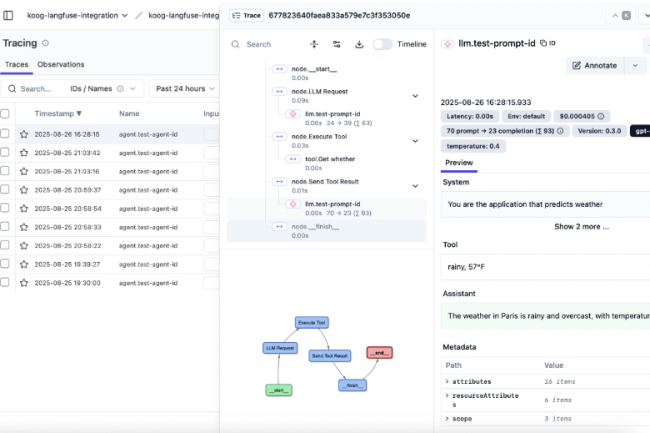

Avec Koog 0.4.0, la prise en charge de GPT-5 et les paramètres LLM personnalisés aident un modèle à « réfléchir » davantage sur des paramètres complexes. Selon JetBrains, des paramètres comme reasoningEffort équilibrent la qualité, le coût et la latence pour chaque appel. Quant au support d’OpenTelemetry, il prend en charge à la fois la boîte à outils de développement W&B Weave AI et la plateforme d’ingénierie LLM open source Langfuse.

Les développeurs peuvent installer le plugin souhaité sur n’importe quel agent et le pointer vers un back-end. Ils pourront voir les événements d’agent imbriqués ainsi que la répartition des jetons et des coûts par requête. Pour faire face aux délais d’appel LLM, aux dysfonctionnements des outils et aux problèmes de réseau, Koog 0.4.0 ajoute RetryingLLMClient, avec des préréglages Conservative, Production et Aggressive. Un contrôle précis et la prise en charge du modèle DeepSeek sont également proposés.