Avec le SLM Mu, Microsoft automatise les réglages de Windows 11

La firme de Redmond a mis au point un SLM (small langage model) capable de gérer les paramétrages dans Windows 11. Cette fonction de GenAI, nommée Mu, est disponible pour les PC Copilot+ équipés d’un NPU.

Alors que les grands modèles de langage (LLM) tels que GPT-4 ou Gemini captent toute l’attention, Microsoft mise également sur des solutions plus légères pour équiper les derniers PC Copilot+. C’est dans cette démarche que la société a récemment présenté Mu, intégré à l’application Paramètres de Windows 11. Ce modèle est capable de contrôler le système d’exploitation en langage naturel, sans avoir à naviguer dans des menus complexes. Par exemple, il suffit de dire « activer le mode sombre » ou « agrandis le curseur de la souris » pour que l’action soit réalisée automatiquement. Mu est un petit modèle de langage (SLM) de 330 millions de paramètres, conçu pour fonctionner intégralement en local, sans nécessiter de connexion Internet.

Il utilise le NPU intégré aux PC Copilot+ lancés en juin 2024 par Microsoft et ses partenaires, parmi lesquels Dell, HP, Lenovo, Samsung et Acer. Ces puces dédiées peuvent exécuter au moins 40 000 milliards d’opérations par seconde (40 Tops), assurant à Mu un fonctionnement fluide et rapide. Microsoft a travaillé avec Qualcomm, AMD et Intel pour garantir que Mu soit compatible et performant sur leurs différentes plateformes NPU.

L’architecture encodeur-décodeur au cœur de Mu

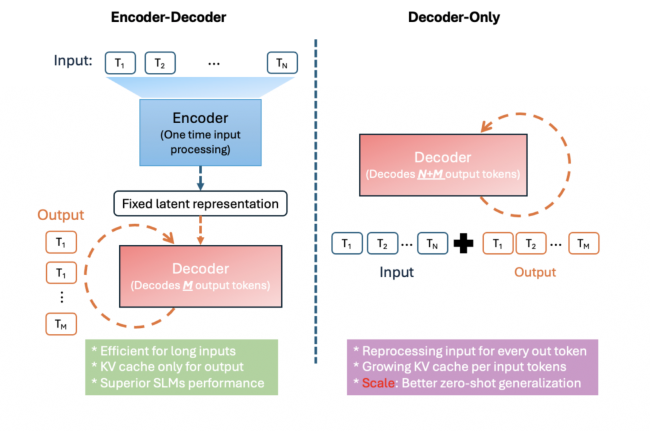

Mu repose sur une architecture transformeur de type encodeur-décodeur. Le premier modifie les mots en une représentation compressée, tandis que le décodeur génère la réponse ou la commande appropriée. Cette configuration, qui comprend 32 couches d’encodeur et 12 couches de décodeur, est optimisée pour la mémoire et la vitesse des NPU. Techniquement, ce dernier emploie des méthodes pour conserver l’ordre des mots, une normalisation pour la stabilité, et un mécanisme pour une utilisation efficace de la mémoire. Résultat : l’outil peut traiter plus de 100 tokens par seconde et répondre en moins de 500 millisecondes, ce qui le rend très réactif comparé aux grands modèles dans le cloud.

Le modèle a été entraîné sur 3,6 millions d’exemples focalisés sur les paramètres et fonctions de Windows, sur la plateforme Azure avec des GPU Nvidia A100. Après cet entraînement, il a été affiné et quantifié pour réduire son empreinte mémoire, lui permettant de fonctionner sur les NPU des principaux fabricants. Résultat : Mu ne représente qu’environ un dixième de la taille de Phi-3.5-mini, tout en offrant des performances comparables sur les cas d’usage pour lesquels il a été conçu.

Architecture encodeur-décodeur par rapport à l’architecture décodeur uniquement (Crédit: Microsoft)

Vers une généralisation des SLM embarqués

Mu se distingue comme le premier modèle de langage spécifiquement conçu pour contrôler les réglages système en langage naturel, sans recourir au cloud. Ce fonctionnement local présente plusieurs avantages : confidentialité renforcée, conformité aux réglementations sur la protection des données, sobriété énergétique et réactivité accrue.

À mesure que les NPUs se généralisent dans les PC, smartphones, tablettes et objets connectés, les SLM pourraient devenir la norme pour les interactions homme-machine. Commandes vocales, actions contextuelles et automatisation locale sont appelées à remplacer des interfaces complexes ou dépendantes du cloud. Ce type de modèle est aussi amené à coexister avec des LLM plus puissants pour des tâches créatives ou métier, avec une exécution répartie entre cloud et en local.